Criticism of the transparent battlefield – What language models and big data mean in war

Kritik des gläsernen Gefechtsfeldes – Was Sprachmodelle und Massendaten im Krieg bedeuten

Christian Heck (2023), „Kritik des gläsernen Gefechtsfeldes – Was Sprachmodelle und Massendaten im Krieg bedeuten“, in W&F Wissenschaft und Frieden 4/2023 “40 Jahre W&F”, Hrsg. Wissenschaft und Frieden e.V. (Köln: 2023). Nachdruck in FIfF-Kommunikation 2/2023 “Wissenschaft für den Frieden”, Hrsg. Forum InformatikerInnen für Frieden und gesellschaftliche Verantwortung (FIfF) e.V. (Bremen: 2023).

Published in:

Download the article: as PDF (in german language)

&

Download the article: as PDF (in german language)

»Kritik des gläsernen Gefechtsfeldes – Was Sprachmodelle und Massendaten im Krieg bedeuten«

Abstract:

The “transparent battlefield” is crucial for “Warfare 4.0”. But the “Internet of Military Things” (IoMT), “Multi Domain Operations” and “Battle Management Systems” are not only highly critical instruments in military terms, but also due to their operational logic. The trend towards more and more machine learning components being implemented in these systems currently seems unstoppable. However, contrary to public opinion, AI is not a “black box”. It consists of many “white boxes” into which we can look. The only thing we are not yet able to do is to open them up mentally in order to learn to understand their inner workings for machine-generated meaning. It is therefore necessary to adequately criticize the fundamental premises of these systems. In particular, the significance that is now attributed to them for military action must be all the more reason for renewed criticism, which is set out in this article.

Für die »Kriegsführung 4.0« ist das »gläserne Gefechtsfeld« ausschlaggebend. Doch das »Internet of Military Things« (IoMT), »Multi Domain Operations« und »Battle Management Systeme« sind nicht nur militärisch, sondern auch aufgrund ihrer Operationslogik hochgradig kritikwürdige Instrumente. Der Trend zu immer mehr Komponenten des Maschinellen Lernens, die in diese Systeme implementiert werden, scheint derzeit unaufhaltbar. KI jedoch, ist entgegen der öffentlichen Meinung keine »Blackbox«. Sie besteht aus vielen »Whiteboxes« in die wir hineinsehen können. Einzig sie zu erschließen, um ihre inneren Funktionsweisen zur maschinellen Bedeutungsgenerierung verstehen zu lernen, dazu sind wir noch nicht in der Lage. So gilt es, die grundsätzlichen Prämissen dieser Systeme adäquat zu kritisieren. Insbesondere die Bedeutung, die ihnen mittlerweile für kriegerisches Handeln zugemessen wird, muss umso mehr Anlass für erneute Kritik sein, die in diesem Beitrag ausgeführt wird.

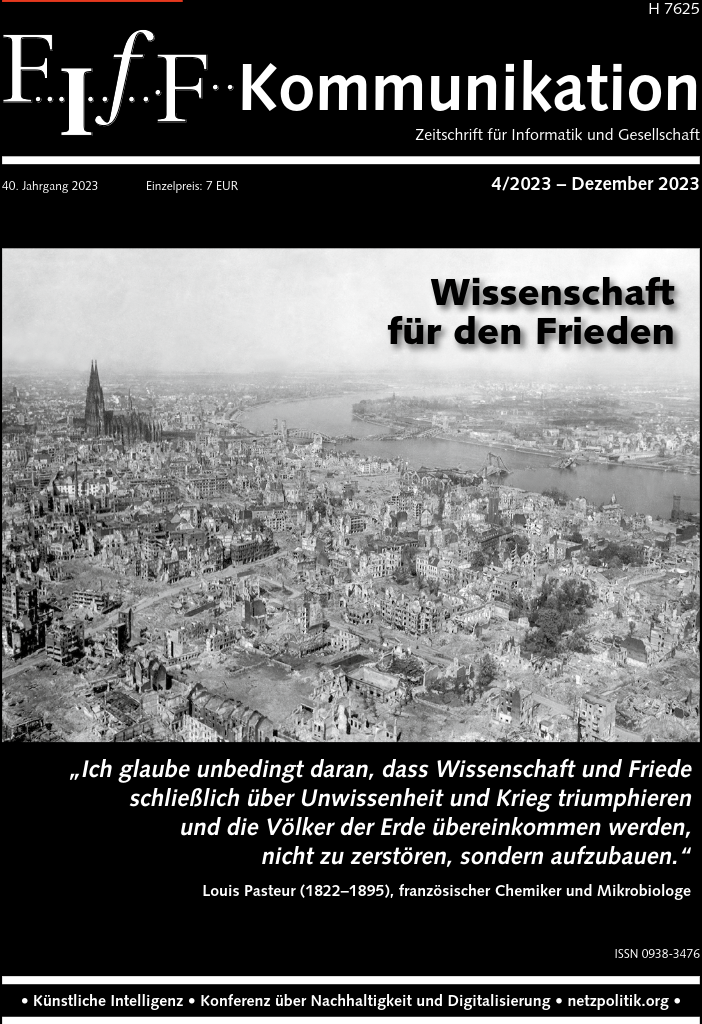

Electronic Warfare in today’s military environment (Bildquelle: Joint Air Power Competence Centre (JAPCC))

Die letzte sogenannte »Revolution in Military Affairs«, die vernetzte Kriegsführung (»Network Centric Warfare« (NCW)) der späten 1990er Jahre, in der technologische Innovationen gezielt zur Vernetzung vieler Informations- und Aufklärungssysteme miteinander gestaltet wurden, wurde im 2. Golfkrieg erstmals durch die US-Streitkräfte als Testfeld unter Beweis gestellt. Es entwickelte sich in der Folge eine systemische Denkweise von Militärtheoretiker*innen, dass durch ein integratives Verständnis von Einzelkomponenten exponentielle Leistungssteigerungen des Gesamtsystems in seiner militärischen Wirksamkeit erreicht werden können. Dieses frühe »Internet der Dinge« (IoT) verwob sich zunehmends mit dem Internet, das wir heute kennen: mit Sozialen Netzwerken, IT-Monopolen und Clouds, die riesige Rechenzentren weltweit zu Big Data durch Deep Learning1 und weiteren neuen technischen kognitiven Systemen verrechnen. Ein Auftakt ins neue Jahrtausend.

Ein Jahrtausend hybrider Konflikte und »gläserner Gefechtsfelder« mit Kampfhandlungen in unseren Städten, im Netz, sowie auch im Weltraum. Das »Internet of Military Things« (IoMT) und die »Kriegsführung 4.0« entwickelten sich demnach aus zahlreichen Spin-in und Spin-off Effekten, d.h. Innovationen aus Industrie, Wirtschaft und Gesellschaft, die vom Militär übernommen wurden und umgekehrt. Militärtechniken fanden auf diese Weise Eingang in unsere zivilen Räume. In öffentliche und private Räume, in denen wir uns bewegen und miteinander sprechen, bzw. chatten.

Eine technisch erzeugte Wirklichkeit

Um »Multi Domain Operationen« (MDO) auszuführen, das heißt sich innerhalb dieser neu ausgeschriebenen Gefechtsfelder zurechtzufinden, Objekte und Situationen zu erkennen, sie adäquat einschätzen zu lernen, um daraufhin besten Gewissens Entscheidungen treffen zu können, hierfür benötigen Soldatinnen und Soldaten in Operationszentralen technische kognitive Systeme, sogenannte »Battle Management Systeme« (BMS), zu deutsch: digitale Führungssysteme. Technische Systeme, die speziell für diesen Zweck entwickelt wurden, nämlich zur menschlichen Entscheidungsunterstützung, da die notwendigen Erkenntnisse innerhalb dieser Art der High-Tech-Kriegsführung nur durch Unterstützung von Technologien erlangt werden können. Diese digitalen Führungssysteme versprechen Einsatzschnelligkeit – und in der Vision von MDOs soll dies heißen, nicht nur möglichst schnell, d.h. in Echtzeit, sondern seiner Zeit voraus zu handeln. Doch diese, innerhalb gläserner Gefechtsfelder durch und durch technische Zeiteinheit ist nicht für den Menschen gemacht, sondern zur möglichst fehlerfreien Funktionstüchtigkeit der technischen Systeme selbst. So auch die Interpretation anfallender Datenströme, die im gläsernen Gefechtsfeld in Echtzeit in militärisch-technische Handlungen überführt werden muss. Auch diese ist nicht für den Menschen gemacht und er wird die undenkbare Masse an Daten nicht alleinig bewältigen können, sei er noch so gut ausgebildet. Hierfür braucht es technische kognitive Systeme auf aktuellem Stand und ein ausgefeiltes »Man Machine Teaming« (MMT).

Dies bedeutet jedoch auch, dass im gläsernen Gefechtsfeld kognitive Technologien das meiste das man wahrnehmen und erkennen kann, auch erst herstellen. Dass das gläserne Gefechtsfeld also eine technisch erzeugte Wirklichkeit ist. Unter anderem deshalb ist es in Multi Domain Operationen zwingend notwendig zur eigenen technischen Handlung während der militärischen Operationen Distanz einnehmen zu können, was Trennlinien zwischen technischer und menschlicher kognitiver Leistung zu setzen erfordert.

Fakt ist: da es bei militärischen Operationen meist um Leben und Tod geht, muss ethisch die letzte Entscheidung beim Menschen liegen. Zugleich müssen Führungskräfte, Beamt*innen und politische Entscheidungsträger*innen aber auch anerkennen, dass die jeweilige Entscheidungsfindung ohne technische kognitive Systeme nicht realisierbar ist. Sie müssen sich hierfür also eher eine innere als eine analytische oder formale Grenze setzen. Eine Grenze zwischen dem Gewissen und einer Entscheidung, die auf technischer Kognition basiert.

Es ist die spezielle Art dieser technischen Systeme, die menschlichen Akteuren und nicht-menschlichen Artefakten eine gänzlich neue aktive politische Handlungskraft einräumt. Auch jenen Akteuren und Artefakten, die in früheren Operationspraxen eine unwichtige, bisweilen gar keine Rolle, zumindest aber eine andere spielten: Dazu zählen bspw. Betreiber*innen von Cloudplattformen, Rechenzentren und Satellitenanlagen, kriegspropagandistische Influencer*innen oder eben Battle Management Systeme.

Die Integration von großen Sprachmodellen

Erste Komponenten für MD-Operationen wurden bereits in den frühen 1980er Jahren in den Militärapparat implementiert. Hans-Jörg Kreowski erinnerte in seinem Artikel »Die militärische Seite der Digitalisierung« (Kreowski 2023) bspw. an die »Strategic Computing Initiative (SCI)« aus dem Jahr 1983, die das US-Verteidigungsministerium bereits Jahrzehnte vor der Notwendigkeit von Multi Domain Operationen in gläsernen Gefechtsfeldern startete. Mit SCI sollten KI-Projekte entwickelt werden, bei denen neben dem Design autonomer Landfahrzeuge auch die Konzeption eines frühen BMS und eines Sprachassistenten für die Pilot*innen der Luftwaffe zur Aufgabe standen.

Die jüngste Generation von Software-Produkten, die aus diesem Ansatz heraus entwickelt wurden, ist im April diesen Jahres auf dem Markt erschienen. Wenige Monate darauf, im September ’23 unterzeichnete das erste Rüstungsunternehmen einen Vertrag mit dem Hersteller, dem US-amerikanischen Datenanalyse-Unternehmen »Palantir« (vgl. Palantir Technologies 2023a). Mit ihrer digitalen Plattform »AIP for Defense« (Palantir Technologies 2023b) werden große vortrainierte Sprachmodelle mit künstlichen neuronalen Einbettungen (LLMs) für militärische Operationen nutzbar gemacht.

Das Unternehmen selbst wurde 2004 gegründet und nahm in diesem Jahrtausend u.a. im »Krieg gegen den Terror« eine bedeutende Rolle ein. Es spezialisierte sich schnell auf die Überwachung von Individuen und die Zusammenführung eigentlich getrennter Datenbestände und wurde somit ein wichtiger Akteur in hybriden und asymmetrischen Kriegsführungsstrategien.

Ihre Datenbankvisualisierungs- und Analyse-Software »Gotham« wurde unter anderem zuerst von der »Joint Improvised-Threat Defeat Organization« (JIEDDO) getestet, einer Einheit des US-Verteidigungsministeriums (DoD), die eingerichtet wurde, um einem neuen Phänomen in dieser Art des Krieges entgegenzuwirken: dem von Anschlägen mit improvisierten Sprengsätzen (»Improvised Explosive Devices« (IED)), mit Autobomben, Paketbomben, Selbstmordattentaten, etc. Die CIA, die NSA und das FBI wurden ziemlich schnell zu Kunden von Palantir. Auch die Europäische Polizeibehörde »Europol« nutzt inzwischen Produkte von Palantir für die Datenauswertung. In der Bundesrepublik wird Palantirs »Gotham« u.a. in Bayern als »Verfahrensübergreifende Recherche- und Analyseplattform« (Vera) eingesetzt. Auch die Polizei in NRW hat mit der »Datenbankübergreifende Analyse und Recherche Software« (DAR) Software von Palantir in Betrieb. In Hessen wurde Gotham in der Polizei-Software »HessenData« seit 2017 eingesetzt. Die Landesregierung in Hessen hatte die Anschaffung der Software freigegeben gehabt, doch der Einsatz wurde im Februar 2023 vom Bundesverfassungsgericht in Karlsruhe als verfassungswidrig eingestuft. Soweit bekannt, führt das System Daten aus sozialen Medien mit Einträgen in verschiedenen polizeilichen Datenbanken sowie Verbindungsdaten aus der Telefonüberwachung zusammen, um mögliche Straftäter*innen zu ermitteln. Zudem spielte Palantir eine nicht unerhebliche Rolle im Skandal um »Cambridge Analytica«. Das Unternehmen soll Facebook bei der Auswertung der illegal weitergegebenen Daten geholfen haben.

Palantirs neuestes Softwarepaket »AIP for Defense« nun, wird in naher Zukunft Einsätze unterstützen, indem es u.a. feindliche Stellungen erkennt und durch eine Chatfunktion ähnlich dem Interface der international viel diskutierten KI »ChatGPT« Gegenmaßnahmen vorschlägt und gegebenenfalls autonom ausführt – wie z.B. das Starten einer Aufklärungsdrohne ins Zielgebiet. Doch nicht nur das Interface mit integrierter Chatfunktion erinnert an ChatGPT, auch das maschinelle Lernverfahren in AIP ist ein ähnliches wie bei OpenAI’s Künstlicher Intelligenz hinter ChatGPT: Das generative Sprachmodell GPT-3 (Generative Pretrained Transformer 3).

GPT-3 ist ein LLM, dessen 175 Milliarden Parameter auf Clouds trainiert werden, die über viele Rechenzentren verteilt sind und dessen Entwicklung derzeit an physische und auch ökologisch tragbare Grenzen stößt. Der Stromverbrauch für das Training entspricht dem von 3000 europäischen Durchschnittshaushalten, eine Frage an ChatGPT benötigt 1000 Mal mehr Strom als eine Suchanfrage bei Google und für jede Antwort, die man von dem Bot erhält, könnte man ein Smartphone bis zu 60-mal aufladen.

Vermutlich ist AIP for Defense eines der ersten Battle Management Systeme, die LLMs implementiert haben.

Wie maschinell Bedeutung generiert wird

Bisher hatten LLMs wie eben GPT-3, bzw. GPT-4, LaMDA und PaLM von Google oder LlaMA von Meta in digitalen Führungssystemen eine eher kleine, bis gar keine Rolle gespielt. Etablierteren Ansätzen bei der komputativen Verarbeitung natürlicher Sprache (NLP2), kann auf der anderen Seite schon seit Jahren eine Art Schlüsselrolle zugeschrieben werden.

Der Sozialpsychologe und Sozialwissenschaftler James W. Pennebaker fasste eines der Hauptargumente hierfür wie folgt zusammen: „Die Worte, die wir im täglichen Leben verwenden, spiegeln wider, worauf wir achten, woran wir denken, was wir zu vermeiden versuchen, wie wir uns fühlen und wie wir unsere Welt organisieren und analysieren.“ (Tausczik und Pennebaker 2010, S. 25)

Die Entwicklung von »Word embeddings«3, zu deutsch: Worteinbettungen, eröffnete hierfür einen gänzlich neuen Handlungsspielraum in der komputativen Sprach- und Netzwerkanalyse.

Zur Extraktion inhaltlicher Strukturen, Features, Organisationseinheiten etc., werden aus einer Vielzahl von generierten semantischen Beziehungen zwischen Wörtern und Sätzen symbolische Repräsentationen in Sprachmodellen mit künstlichen neuronalen Einbettungen errechnet. Eingebettet in digitale Führungssysteme, kommen die Wörter und Sätze, die es zu berechnen gilt u.a. aus »Open Source Intelligence«-Datensätzen (Medienberichte, Social Media, wissenschaftlichen Arbeiten, öffentlich zugänglichen Statistiken etc.), aus Berichten von Geheimdiensten, des militärischen Nachrichtenwesens, Analysen von Sicherheitsbehörden, Erkenntnissen aus der signalerfassenden Aufklärung, der Bild- und Satellitenaufklärung, von Bots, Drohnen und anderen technischen kognitiven Systemen bzw. unbemenschten Fahrzeugen. Die jeweiligen »Lern«-Kriterien, nach denen maschinell Bedeutungen generiert werden, liegen in diesen Sprachmodellen verankert. Nach ihnen werden Millionen von Gewichtungen, die an den einzelnen künstlichen Neuronen liegen, eingestellt. Eine undenkbare Anzahl an Rechenprozessen findet in diesen Künstlichen Neuronalen Netzen statt, sowie auch eine undenkbare Masse an Informationen ausden unterschiedlichsten Quellen für diesen Prozess gesammelt wird. Sie wird daraufhin übersetzt, selektiert, kategorisiert und mit strukturierten Daten angereichert. Sie wird enkodiert, d.h. maschinenlesbar gemacht (»machine readable«), um sie zu einem späteren Zeitpunkt wieder für Menschen lesbar zu machen (»human readable«). Auf diese Weise findet fast unsichtbar eine maschinelle Vorinterpretation statt. Eine Menschenlesbarmachung von maschinell erlernten symbolischen Repräsentationen, die nach vorgegebenen Regeln, sprich, ihren inneren Funktionsweisen, die im Code verankert sind, vonstatten geht.

Als vor zehn Jahren, im Jahr 2013 erstmals ein vortrainiertes Sprachmodell mit künstlichen neuronalen Einbettungen, nämlich »Word2vec« von einem Google-Forscherteam veröffentlicht wurde, galt dies als ein Durchbruch in den NLP-Forschungsgemeinden. Word2vec wurde zügig in zahlreiche Anwendugen, u.a. auch der inneren und äußeren Sicherheit implementiert und ist bis heute noch eines der gebräuchlichsten Modelle zur Generierung von Worteinbettungen mittels Deep Learning. Die von Word2vec erzeugten Worteinbettungen konnten einfach und bequem zur Weiterverarbeitung verwendet werden und zugleich konnte das KI-Modell Ergebnisse auf dem neuesten Stand der Technik (ca. 2013-15) liefern.

Die inneren Funktionsweisen vortrainierter Sprachmodelle mit künstlichen neuronalen Einbettungen, egal ob LLMs oder Word2vec, beruhen auf der Idee, dass im Gegensatz zur formalen Linguistik und zur Chomsky’schen Tradition allein die Kontextinformation eine brauchbare Darstellung sprachlicher Elemente darstellt. Je nach Modell werden hier einzelne Wörter eines Korpus (Textes) als symbolische Repräsentationen in einem semantischen Vektorenraum (Wortraum) mit etwa 300 Dimensionen dargestellt. Zum Vergleich: in heutigen Transformer-Architekturen à la GPT-3 werden 1536 Dimensionen pro Wort errechnet. Worteinbettungen repräsentieren also den innertextlichen Kontext eines Datensatzes, in dem das jeweilige Wort vorkommt.

Niemanden interessiert wie es funktioniert, solange es funktioniert

Das Studium aktueller NLP-Forschungsarbeiten zeigt, dass trotz der weit verbreiteten Anwendung von künstlichen neuronalen Worteinbettungen noch immer erstaunlich wenig über die Struktur und die Eigenschaften – und folglich auch den Konsequenzen – dieser Einbettungsräume bekannt ist. Dennoch werden zunehmende Teile von Welt in symbolische Repräsentationen umgewandelt.

So fließen immer wieder auftauchende, bisweilen diskriminierende Tendenzen, bis hin zu Rassismen in digitale Führungssysteme mit ein. Sogenannte »Verzerrungen«, die diesen textanalytischen Machine-Learning-Verfahren zwar nicht explizit, auch nicht vorsätzlich eingeschrieben werden, die aber dennoch im realweltlichen Gebrauch in Erscheinung treten. Denn trotz dieser bekannten und insbesondere in den letzten 3-4 Jahren auch in der Öffentlichkeit verhandelten Defizite von KI-Sprachmodellen, implementieren Firmen diese weiterhin in ihre Produkte und verkaufen sie an Sicherheitsbehörden und an das Militär.

Der Trend hin zu immer größer werdenden Modellen und immer mehr (unüberprüften) Trainingsdaten in den letzten Jahren, führt auch zu einer immer schlechter werdenden Kontrollierbarkeit der inneren Funktionsweisen von technischen kognitiven Systemen. Funktionsweisen, durch die Minderheiten diskriminiert und gesellschaftliche Gruppen marginalisiert werden, und das auf eine Weise, die meist den Entwickler*innen selbst nicht bekannt, bzw. bewusst, schlimmstenfalls egal ist (vgl. Bender et al. 2021).

Auch aus diesem Grund ist es für Soldatinnen und Soldaten in Operationszentralen oder in Ämtern und Firmen, die die analytische Ausarbeitung für Führungskräfte unterstützen, unabdingbar, sich ein grundlegendes Verständnis des inneren Aufbaus dieser technischen kognitiven Systeme anzueignen. Denn die Bedeutung der jeweiligen militärisch-technischen Handlung, muss aus diesen Systemen heraus, also in deren inhärenter Pragmatik erschlossen werden.

Aus technischen kognitiven Systemen, die neben ihrer natürlichen Begrenztheit zugleich auch eine scheinbare Grenzenlosigkeit zu Tage fördern. Eine Grenzenlosigkeit, die in ihrem Lern-Vermögen liegt, die uns derzeit zugleich aber auch bis zur Entgrenzung unseres Denkens führt. Denn diese technischen Systeme können „sowohl lernen, dass die Erde flach ist, als auch rund“ (Chomsky et al. 2023), so Noam Chomsky (linker Intellektueller, Anarchist und emeritierter Professor für Linguistik am Massachusetts Institute of Technology, MIT) im März ’23 in der »New York Times«. Sie können auch lernen, dass seit inzwischen fast zwei Jahrenweit über einem Jahr ein von Russland geführter Angriffskrieg gegen die ukrainische Bevölkerung wütet. Im nächsten Moment können sie dies jedoch auch wieder verlernen, egal ob es der Wirklichkeit entspricht oder nicht. Was diese technischen kognitiven Systeme eben nicht können, ist ihre innere Grenzenlosigkeit durch ethische Prinzipien einzuschränken. Eine Eigenschaft, die wir als »moralisches Denken« bezeichnen. Während des Lern-Prozesses, d.h. der Einstellung von 175 Milliarden Parametern in ihrem Inneren, sind technische kognitive Systeme getrennt von der Außenwelt. In ihren inneren Entscheidungsfunktionen liegen keine Modellierungen von dem, was Worte, was Dinge, was Taten und Ereignisse für uns in der Welt bedeuten. Dennoch werden sie, implementiert in militärischen Softwareanwendungen über Leben und Tod von Soldatinnen und Soldaten, von Jugendlichen, von Großeltern, von Eltern und unseren Kindern algorithmisch mitentscheiden.

Footnotes:

1: Die Technologie des »Deep Learning« begann sich um die Jahrtausendwende zu entfalten. Es begann bald darauf die Zeit von Big Data (dem Anstieg der Datenmengen durch die Verbreitung der Internettechnologien) und es wurden erhebliche Fortschritte in den Computertechnologien (in der Rechenkapazität, GPUs und preiswerten Speichertechnologien) erzielt. Erst durch diese technische Infrastruktur wurde die Weiterentwicklung der Künstlichen Neuronalen Netze (KNN) hin zum Deep Learning im Forschungs- und vermehrt auch im Anwendungsbereich möglich. Von dieser Technologie sprechen wir heute in erster Linie, wenn von Künstlicher Intelligenz zu hören ist: der subsymbolischen Künstlichen Intelligenz.

2: Das Kürzel NLP steht für Natural Language Processing. Eine Mischwissenschaft, die anteilig aus der Computerlinguistik, den Computerwissenschaften und der Künstliche Intelligenz Forschung besteht. Sie ist eine Wissenschaft der algorithmischen Verarbeitung von Sprache, der Verarbeitung von Daten und des künstlich intelligenten Verhaltens zugleich.

3: Der Sammelbegriff »Word embeddings« steht für eine Reihe von Sprachmodellierungs- und Feature-Learning-Techniken in NLP, bei denen Wörter oder Phrasen aus dem Vokabular auf Vektoren mit reellen Zahlen abgebildet werden: z.B. eine globale Korpusstatistik (GloVe: Globale Vektoren für Wortdarstellung) oder eine Wortkontextdarstellung (Word2vec), siehe Mikolov et al (2013).

Literatur:

- Bender, E. M.; Gebru, T.; McMillan-Major, A.;; Shmitchell, Sh. (2021): On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? FAccT ’21: Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency, S. 610-623.

- Chomsky, N.; Roberts, I.; Watumull, J. (2023): The False Promise of ChatGPT. New York Times, 8.3.2023.

- Kreowski, H.-J. (2023): Die militärische Seite der Digitalisierung. IMI-Ausdruck 113, S. 25-27.

- Mikolov, T.; Sutskever, I.; Chen, K.; Corrado, G.; Dean, J. (2013): Distributed Representations of Words and Phrases and their Compositionality. NIPS’13: Proceedings of the 26th International Conference on Neural Information Processing Systems – Volume 2, S. 3111–3119.

- Palantir Technologies (2023a): Palantir Technologies Signs Partnership With Titan Defence Firm, Babcock. Pressemitteilung, 13.9.2023.

- Palantir Technologies (2023b): AIP for Defense. Homepage, URL: palantir.com/aip/defense/.

- Tausczik; Y. R.; Pennebaker, J. W. (2010): The Psychological Meaning of Words: LIWC and Computerized Text Analysis Methods. Journal of Language and Social Psychology 29 (1), S. 24-54.