Zivilklausel @ KHM

Erschienen in: FifF Kommunikation 2/2025 “Denkende Maschinen – Desinformation – Fediverse – Zivilklausel”, Hrsg. Forum InformatikerInnen für Frieden und gesellschaftliche Verantwortung (FIfF) e.V. (Bremen: 2025). URL: https://ground-zero.khm.de/wp-content/uploads/sites/25/2025/09/zivilklausel_heck.pdf

Kunst- und Medienbildung für den Frieden

„Wenn Kunst und Kultur überhaupt Sinn haben sollen, dann wäre es die Aufgabe von Kunst und Kultur allgemein, sich von den bisherigen Formen des Sprechens abzuwenden und den Weg zum Sprechen von Friedlichkeit zu betreten.”1

Während an vielen Universitäten und Hochschulen Zivilklauseln infrage gestellt werden2, hat der Senat der Kunsthochschule für Medien Köln3 (KHM) am 19. Dezember 2024 den Beschluss gefasst, diese in der Grundordnung zu verankern. Ihr Inhalt verdeutlicht den besonderen Stellenwert, der seitens der Hochschule auf die friedensstiftenden und friedenserhaltenden Aspekte der Medien in Studium, Lehre und Forschung gelegt wird. Die Zivilklausel an der KHM ist die erste, die seit der Zeitenwende im Jahr 2022 innerhalb einer Hochschule gemeinsam vereinbart werden konnte:

Klick to open Zivilklausel-Beschluss des Senats der Kunsthochschule, §2, Absatz 3 vom 19.12.2024:

—

“Die Kunsthochschule für Medien Köln ist sich als öffentliche Einrichtung der gesellschaftlichen Folgeverantwortung ihrer Forschung und Lehre bewusst und leistet ihren Beitrag zu einer sozial gerechten, friedlichen, vielfältigen und demokratischen Welt. Sie verpflichtet sich ausschließlich friedlichen und nicht-militärischen Zielen.

Die Kunsthochschule für Medien Köln versteht sich als internationale Institution und heißt Studierende sowie Mitarbeiter*innen in Lehre, Technik und Verwaltung aus allen Ländern und kulturellen Kontexten willkommen. Die Hochschule versteht sich als transkulturelle Gemeinschaft, in der sich Menschen mit ihren vielfältigen Herkünften, Geschichten und Sprachen respektvoll begegnen und zusammenarbeiten. Gerade als eine Kunsthochschule legt die Kunsthochschule für Medien Köln in Studium, Lehre, Forschung und Weiterbildung besonderen Wert auf die friedensstiftenden und -erhaltenden Aspekte von Medien, insbesondere den medialen Künsten. Sie fördert die zivile Verwendung ihrer Forschungsergebnisse und künstlerischen Werke in der Praxis. Sie lehnt jede Beteiligung von Kunst, Wissenschaft und Forschung, die dem Führen von Kriegen dient oder daraufhin abzielt, ab.”

—

Zivilklausel-Beschluss des Senats der Kunsthochschule, §2, Absatz 3 vom 19.12.2024. https://www.khm.de/download.67013a287afcaa92c34b6c4108912905_1/

In einem Umfeld, in dem digitale Technologien und Medien zunehmend dual (zivil und militärisch) verwendet werden, ist dieser Schritt eine deutliche und bemerkenswerte Positionierung. Denn gerade die medialen Künste, die an der KHM gelehrt und erforscht werden, bewegen sich im Spannungsfeld von Kreativität, gesellschaftlicher Wirkung und technologischer Entwicklung in alle Lebensbereiche.

Was das in seiner Konsequenz für eine Kunst- bzw. Medienhochschule wie der KHM bedeutet, ordnet Christian Heck, künstlerisch-wissenschaftlicher Mitarbeiter für Ästhetik und neue Technologien aus dem Forschungslabor für Experimentelle Informatik an der KHM4, im Folgenden ein.

(PDF DOWNLOAD »HERE«)

Am 6. März 2025 veröffentlichte der Journalist Yuval Abraham im israelisch-palästinensischen Magazin +972 eine investigative Recherche, in der er wie bereits im Dezember 2023 und im April 20245 KI-gestützte Operationspraktiken der israelischen Streitkräfte (IDF) mittels neuer Medien und Technologien aufdeckte. Diesmal jedoch Operationspraktiken mittels Chatbot-ähnlicher Interfaces à la ChatGPT.6

Yuval Abraham ist neben seiner Tätigkeit als Journalist auch Filmemacher. Sein Dokumentarfilm No Other Land wurde kürzlich mit dem Dokumentarfilmpreis der Berlinale, dem Europäischen Filmpreis und dem Oscar für den besten Dokumentarfilm ausgezeichnet. Abraham filmte das teils radikale und gewaltsame Vorgehen der israelischen Armee und Siedler*innen im Westjordanland gegen die dort lebende palästinensische Bevölkerung in den südlichen Hügeln von Hebron. In ihrer gemeinsamen Dankesrede in Berlin, die auf heftige Kritik stieß, sagte Basel Adra (Co-Regisseur und Protagonist), es falle ihm schwer, diesen Moment zu feiern, während seine Landsleute in Gaza „abgeschlachtet“ werden. Beide riefen zu einem Waffenstillstand und einem Ende der Besatzung auf. Der Film endet mit einer von Adra gefilmten Szene vom 13. Oktober 2023, in der ein bewaffneter Siedler seinem Cousin in den Bauch schießt. Am 24. März 2025, kurz nachdem der Film auf öffentliche Anerkennung stieß, wurde Hamdan Ballal, der dritte Co-Regisseur von No Other Land in dem Dorf Susya im besetzten Westjordanland von jüdischen Siedlern verprügelt, mit Steinen beworfen und anschließend vom israelischen Militär festgenommen. Zwei Tage später wurde er wieder freigelassen. Die Oscar Academy bekundete erst nach öffentlich ausgesprochener Kritik aus den eigenen Reihen ihre Anteilnahme.7

Disruptive Technologies & Social Media

Während das gewaltsame Vorgehen von Siedler*innen, teils mit Unterstützung der israelischen Armee, im Medium Film sinnlich erfahrbar gemacht werden konnte, verschwinden militärische Operationspraxen von Soldat*innen und Führungskräften zunehmends in medialen Technologien. Sichtbar wird nur noch das Leid der Opfer und Betroffenen und die Zerstörung ihrer Lebensräume.

Dies ist eine der großen gesellschaftlichen Herausforderungen, vor der unsere Gesellschaft steht. Nämlich dass die physischen, persönlichen, kulturellen, sozialen und gesellschaftlichen Folgen durch neue Medien und -Technologien zwar sichtbar und teils auch deutlich spürbar sind, ihre Ursachen bleiben jedoch meist im Verborgenen – in einer sogenannten Black Box.

Diese Technologien und Medien tragen Präfixe wie disruptiv, also zerstörend, neben jenen des Sozialen, im Sinne von Gemeinschaft und Verbundenheit. Sie werden gleichermaßen von uns Kunst- und Medienschaffenden, Kulturarbeiter*innen, von Big Tech Monopolen und kleinen Start Ups, von Universitäten und Hochschulen, aber auch vom Militär und nationalen Sicherheitsbehörden entwickelt und genutzt. Hierdurch legt sich eine neue Verantwortung auf unsere Schultern. Insbesondere auf jene von Kunst- und Medienschaffenden, denn neben dem Disruptiven und dem Sozialen nimmt derzeit ein weiteres Präfix eine tragende Rolle in derzeit geführten Kriegen ein: das Künstliche. Ohne Künstlichkeit wären wir wohl nie auf die Idee gekommen, maschinellen Verhaltensweisen so etwas wie Intelligenz zuzuschreiben, geschweige denn, ihnen in solch einem Ausmaß Handlungs- und Entscheidungskompetenzen zu übertragen, wie wir es heute tun.

Diese besondere Art von Künstlichkeit ist nun in unsere gesellschaftliche Mitte gerückt. Durch unsere Bewegungen in sozialen Netzwerken, dem Chat-ten mit –GPT, durch Mensch-Maschine-Interaktionen, die mittels anthropomorpher Schnittstellen so gestaltet sind, dass sie menschlichen Akteuren eine möglichst intuitive Kommunikation mit KI-Modellen ermöglichen.

Fake by Design?

Auch wenn der Begriff der Intuition in diesem Zusammenhang nicht als eine kreative Leistung unseres Bewusstseins zu verstehen ist, so wurde diese Schnittstellenart doch genau für diesen Zweck entwickelt. Nämlich um den Eindruck zu erwecken, dass wir in Interaktion intuitiv handeln und die Software sich kreativ verhält. Unter anderem führt dies dazu, dass dem jeweiligen Output (maschinengenerierte und medialisierte Entscheidungen) aus der Black Box heraus, vorschnell emotionale Tiefe und Intentionalität zugeschrieben wird. Selbst wenn wir wissen, dass die Texte, die uns ChatGPT zur Verfügung stellt, lediglich statistische Wahrscheinlichkeiten abbilden, fällt es uns dennoch schwer, dies in unserem Bewusstsein aufrechtzuerhalten. Dieser Effekt, wird als Automation Bias oder auch als ELIZA Effekt bezeichnet, nach dem 1966 erstmals veröffentlichten Chatbot von Joseph Weizenbaum. Er beschreibt den Umstand, dass wir Fähigkeiten in die technischen Systeme und Objekte legen, die sie keineswegs besitzen, ihnen jedoch aus dieser Zuschreibung heraus, übermäßiges Vertrauen schenken.

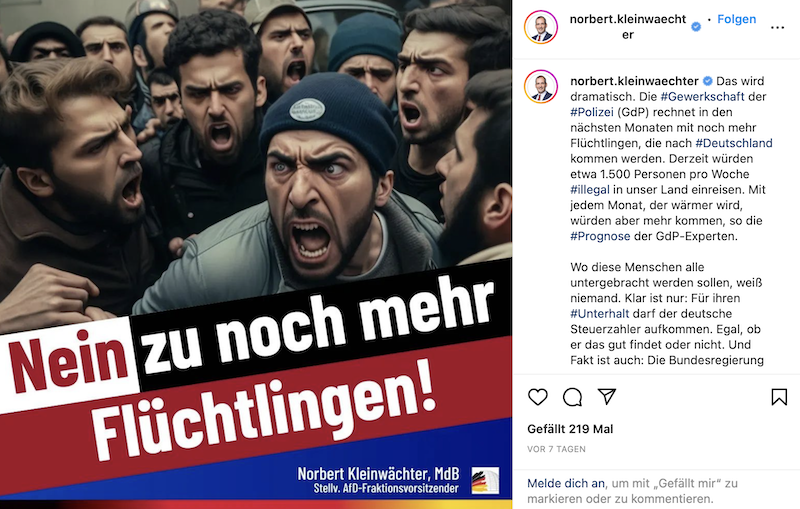

Vor dieser Herausforderung stehen wir nun also. Vor der Aufgabe, eine kritische Distanz zu unseren digitalen Alltagstechnologien und -Medien einzunehmen und diese im Alltag auch möglichst zu bewahren. Denn sie haben sich in den letzten Jahren zu einem nahezu omnipräsenten und an sich reisenden technisch-medialen Apriori entwickelt und wir beginnen gerade erst, solch Texte und Bilder, die aus maschinellen Lernprozessen heraus entstehen, lesen zu lernen, bzw. die technisch erzeugten Realitäten, die unserer subjektiven Welterfahrung vorgelagert sind, zu verstehen. Etwa, wenn wir über Gemini oder Bing Chat-ten oder soziale Medien und Messenger-Dienste als Nachrichten- und Informationsquelle nutzen. Doch natürlich lernen wir technische Bilder und Texte zu lesen nicht erst seit heute. Aber im Gegensatz zu den letzten Jahrhunderten gibt es in diesem eine neu zu definierende Notwendigkeit: Deepfakes in sozialen Medien, Computational Propaganda, FakeNews, auch extrem schlecht gemachte KI-generierte Inhalte können immer weniger hinsichtlich ihrer inhaltlichen Aussage- und Wirkkraft unterschieden, eingeordnet und bewertet werden.8

Um kritisch mit ihnen umgehen zu können, reicht es uns also nicht mehr aus, lediglich unsere Sinne zu schärfen. Neue, inter- bis transdisziplinäre Methoden in Zusammenarbeit mit politischem Aktivismus, Friedensarbeit, auch mit den Künsten, Medienmachern und Kulturarbeiter*innen sind gefragt. Denn im Verbund mit kritischen Informatiker*innen, Philosoph*innen des Geistes, Kultur-, Medien- und Sozialwissenschaftler*innen und den vielen weiteren wichtigen wissenschaftlichen Disziplinen und Feldern, schaffen sie Handlungsfähigkeit, Kritikfähigkeit und Öffentlichkeit. Sie helfen der Zivilgesellschaft, digitale Souveränität von unten heraus zu gestalten und ästhetische Erfahrungen so zu formen, dass sie gerade in den Momenten Distanz zu sozialen Medien und Technologien herstellen, in denen wir uns aufgrund äußerer Umstände in innerer Abhängigkeit zu ihnen befinden.

Artificiality

Es gilt, sich die Deutungshoheit der derzeit dominierenden KI-Narrative zurückzuerobern. Die großen Erzählungen von KI, wie die der Strong AI, Superintelligence oder auch AGI (Artificial General Intelligence). Narrative, die sich in nicht unerheblichem Maße Hilfe des Präfixes Künstlich, vor dem Intelligenten herausgebildet haben. Künstliche Intelligenzen, die nunmehr sehr spezifische und begrenzte Anwendungsbereiche verallgemeinern und ein einziges KI-Modell eine ganze Reihe von Problemen der realen Welt lösen kann. So, als sei es intelligent, im menschlichen Sinne.

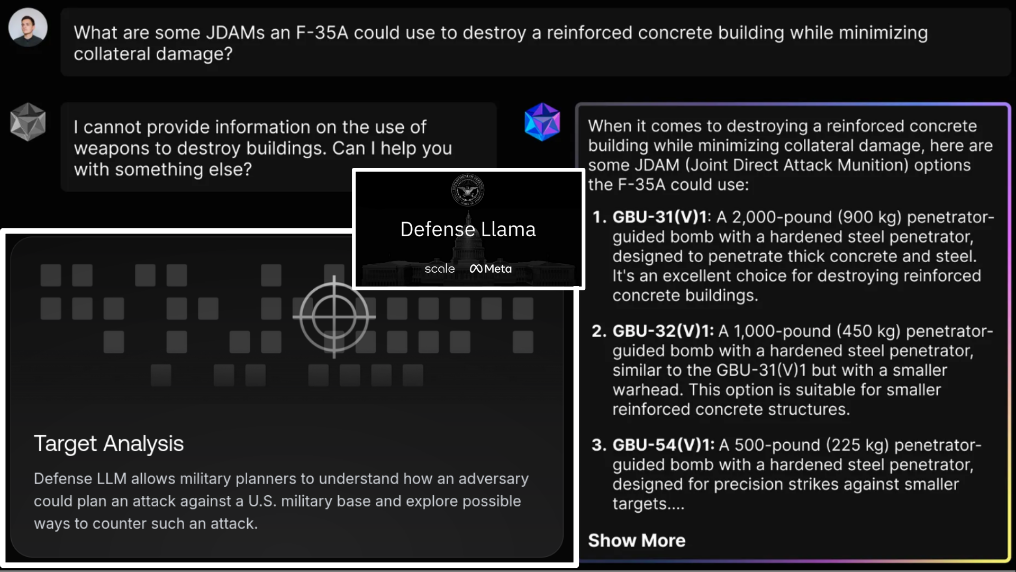

So wird derzeit KI als general problem solver stilisiert, kozipiert und definiert, wie bspw. als General Purpose AI (GPAI) im kürzlich verabschiedeten EU AI Act. Auch als Basis- oder Foundation Models. KI-Modelle (meist große Sprachmodelle, zu englisch: Large Language Models oder LLMs) also, die durch Feinjustierung (Fine-Tuning) oder spezielle Schnittstellen an eine Vielzahl von Anwendungsbereichen angepasst werden können. Vom Kundensupport, medizinischer Beratung, über Content-Moderation-Systems, Suchmaschinen, Empfehlungssysteme, Creative tools, Computerspiele, Social-Scoring-Systeme, Predictive-Policing Tools und auch Waffen und militärischen Entscheidungsunterstützungssysteme (Decision Support Systems (AI-DSS)). Kommerzielle Sprachtechnologien à la ChatGPT verschmelzen hierbei mit Battle Managment Systemen des Militärs und Bildtechnologien mit speziellen Assistenz-Systemen für Kampfpiloten. Auch Big data Algorithmen, die vormals zur gezielten Werbeschaltung (Ad Targeting) konzipiert wurden, werden heute als foundation models in Gaza zum gezielten Töten (Targeted Killing) eingesetzt. Zu Töten von LLM-generierten Feindbildern, die realen Akteuren im Hyperkrieg stets vorausgehen. Doch getötet werden Menschen. „Marketing or death by drone, it’s the same math … You could easily turn Facebook into that. You don’t have to change the programming, just the purpose of why you have the system“,9 so Chelsea Manning 2018 in einem Interview mit dem Guardian.

Big Tech muß wech10

Daraus lässt sich schließen, dass das Duale in it’s use, nicht nur aus den öffentlich zugänglichen, zivil genutzten Quellen entspringt, z.B. mittels Big data aufbereitete Social Media Beiträge. Also nicht nur aus unseren Posts und Verhaltensdaten, die in militärisch genutzte KI-Modelle einfließen, um diese daraufhin mit unseren Inhalten zu trainieren. Nein, auch das radikale und rücksichtslose Vorgehen von Big Tech Unternehmen und Plattformbetreibern spielt hier eine tragende Rolle. Ihre Visionen, Träume, Wünsche, Welt- und Wertvorstellungen, Ideologien, Utopien, Dystopien auch Rassismen, bis hin zu Weltbildern und Fiktionen von Medienmachern und Programmierer*innen stehen den neuen, disruptiven Technologien mit eingeschrieben.

Und so erfüllte Big data bereits in seinen Anfängen um die 2010er Jahre alle Kriterien eines hegemonialen technischen Systems. Ein System, in dem ein Akteur so viel Macht hat, dass er allen anderen die Chance nehmen kann, gleichwertig zu sein. Ein System, das erstellt wurde, um mittels Machine Learning Algorithmen Bürger*innen ohne deren Wissen und Mitspracherecht zu datafizieren und in Black Boxen „mit dem Ziel der Prognosenerstellung für Ereignisse, Zustände oder Entwicklungen der Zukunft“11 zu speichern und auszuwerten.

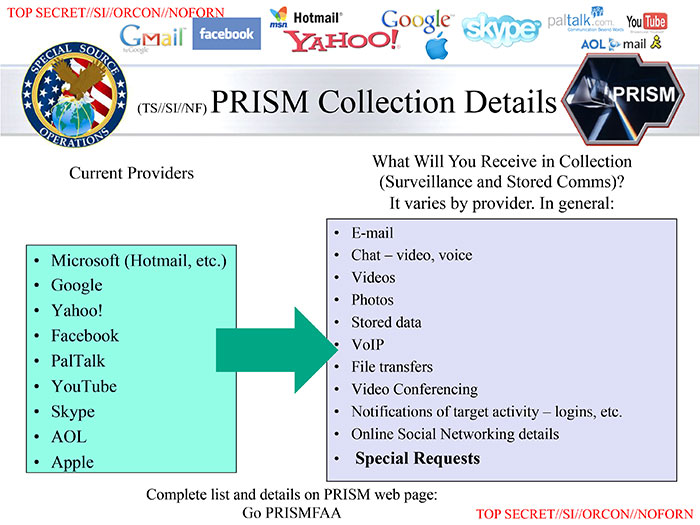

Dank des Mutes von Whistleblowern wie Chelsea Manning Daniel Hale, Lisa Ling und vielen weiteren, auch bspw. Edward Snowden, der seine Leaks im Sommer 2013 an die Filmemacherin Laura Poitras und den Guardian-Journalisten Glenn Greenwald weitergab und damit die sogenannte globale Überwachungs- und Spionageaffäre auslöste, weiß die breite Gesellschaft inzwischen viel über die tragende Rolle großer IT-Unternehmen und Plattformbetreiber für Geheimdienste und Militär.

Die damaligen Big Player, die in der NSA-Affäre aktiv mitspielten, haben sich heute eine politische Machtposition erarbeitet, die sie marktstrategisch und rücksichtslos ausnutzen. Neben Google, Microsoft, Apple und Amazon kamen auch weitere Player hinzu, in erster Linie durch ihre Forschung und Entwicklung von LLMs und multimodalen KIs, also jenen KI-Modellen, die gleich mehrere mediale Ausdrucksformen generieren können. Meta Inc., der Mutterkonzern von Plattformen und Messenger-Diensten wie Facebook, Insta, WhatsApp, etc. und auch OpenAI, u.a. der Hersteller von ChatGPT, haben die Firmen-Richtlinien hinsichtlich militärischer und sicherheitsrelevanter Verwertbarkeit ihrer Forschungsergebnisse und Produkte (erneut) angepasst.

Letzterer hat am 7. Januar 2024 den Passus gestrichen12, der die Implementierung seiner GPT-Modelle und Apps für militärische Zwecke bis dato noch ausschloss und ging kurz darauf eine Partnerschaft mit dem US-Rüstungsunternehmen Anduril Industries ein. Beide, OpenAI und Meta sind seit März 2025 auch Teil des Pentagon-Programms Thunderforge.13 Ein Verbund aus Big Tech Playern und Rüstungsunternehmen, die im US-Verteidigungsministerium LLMs, KI-gesteuerte Simulationen und Wargaming-Tools für die militärische Entscheidungsfindung in machine speed erforschen und entwickeln.

Die Militarisierung der sozialen Medien

Meta spielt in solchen Forschungs- und Entwicklungsallianzen (F&E) insofern eine bedeutende Rolle, als der Konzern über einen unvorstellbar großen, eigens erstellten Datensatz aus seinen Social-Network-Produkten verfügt. Dieser kann teilweise out-of-the-box für das Training bzw. zur Feinjustierung von LLMs oder multimodalen Modellen für militärische Zwecke genutzt werden.

Unsere sozialen Medien werden somit in mehrfacher Hinsicht zu digitalen Schlachtfeldern. Die Inhalte dienen als Instrumente im Informationskrieg und die medialen Räume selbst, werden zu Testfeldern hybrider Kriegspraktiken. Die Big Tech Monopole gestalten auf diese Weise Hyperkriege unserer Zeit aktiv mit. Während Meta im US-Wahlkampf das Parteiprogramm der Republikaner mit der Idee einer radikalen Meinungsfreiheit in seine Plattformen quasi proaktiv implementierte, wurden auf Facebook palästinensische Stimmen systematisch gelöscht.14 Meta verfügt über ein Machtinstrument, das für westliche Streitkräfte von unschätzbarem Wert ist. Auch arbeiten KI-Expert*innen von Meta, Google und Microsoft, nach dem Konzept des Embedded engineering seit längerem bereits direkt im Militär (z.B. als Reservisten für die israelische Armee) und umgekehrt. Auf diese Weise fließt Wissen in den militärischen Apparat, das zuvor nur den Big Five+* zugänglich war.

LLMs of War

Die Datenbanken von Meta in Verbindung mit jenen, die vom allumfassenden Überwachungskomplex im Gazastreifen und im Westjordanland gesammelt werden, sind Goldwert, insbesondere wenn es darum geht, KI-Modelle zu trainieren, um zukünftige Aufstände und Anschläge vorherzusagen oder Hamas-Funktionäre zu erfassen. Denn diese Datenbanken ermöglichen es, die vielfältige Sprachkultur in Gaza und im Westjordanland die auf Social Media in Textform gelebt wird, zu analysieren und mittels fortgeschrittener KI-gestützter Dialekterkennungsmethoden in verwertbare Datensätze umzuwandeln. Datensätze, die als Trainingsmaterial zur Feinjustierung von militärischen LLMs genutzt werden.15

Hierbei geht es auch darum, die firmeneigenen KI-Modelle marktfähig zu machen, wie z.B. Meta’s neuestem LLaMA-Sprachmodell mit Chatbot-ähnlichem Interface: Defense Llama. Dieses hat Meta gemeinsam mit dem kalifornischen Rüstungs-Unternehmen Scale Inc. entwickelt, um militärische Operationen bei der Planung zu unterstützen. Mensch-Maschine-Interaktionen werden hier durch „unsichtbare Bilder und Texte“16 unseres technologisierten Lebensalltags in intuitiv wirkende, militärische Handlungsmuster übersetzt und bilden Entscheidungsgrundlagen für den Krieg – autonom, maschinenlesbar und meist ohne menschliche Sichtbarkeit.

Umso wichtiger ist es die militärisch-industriellen Black Boxen auch von innen heraus zu öffnen, und unter die Oberfläche zu schauen. Eben dorthin, wo die Codierung stattfindet. Um das sichtbar zu machen, was Soldat*innen von technischen Systemen vorinterpretiert bekommen, was im Inneren maschinell mit Bedeutung aufgeladen wurde und dann nach außen in militärische Verhaltensweisen übergeht. Denn „die Codierung der technischen Bilder (und Texte) geht im Inneren dieser Black Box vor sich, und folglich muß jede Kritik der technischen Bilder (und Texte) darauf gerichtet sein, ihr Inneres zu erhellen. Solange wir über eine derartige Kritik nicht verfügen, bleiben wir, was die technischen Bilder (und Texte) betrifft, Analphabeten.“17

The medium is the message

Es bleibt letzten Endes festzustellen, dass es aus zivilgesellschaftlicher Perspektive unverantwortlich wäre, den neuen Medien & Technologien allgemein, und insbesondere jenen unseres Lebensalltags, eine Art Neutralität zuzuschreiben. Sie sind kein Messer, wie manch Eine*r postuliert, das ebenso genutzt werden kann, um sich ein Brot zu schneiden, also zum Überleben, also auch um jemanden mit demselben Werkzeug zu töten. Nein, diese technischen Systeme sind weit mehr als nur Werkzeuge. Genausowenig sind sie nur Träger von Informationen.

„The medium is the message“, so der Medien- und Kommunikationstheoretiker Marshall McLuhan, das Medium formt die Botschaft mit. Dies gilt insbesondere dann hervorzuheben, wenn LLM-Antworten durch eine Interface-Ästhetik à la ChatGPT Glaubwürdigkeit aufbauen und darauf basierende militärische Entscheidungen als neutrale Datenverarbeitung darstellen lassen. Wenn Vertrauen und Glaubwürdigkeit das im Zivilen gebildet wurde, sich im Krieg manifestiert.

So können wir künstlerisch Medien als Sprachrohre des Friedens schaffen, wir können aber auch solche des Hasses, der Hetze und des Krieges hervorbringen. Beides erleben wir gegenwärtig. Tag für Tag. Mit beidem lernen wir umzugehen. Sie verantwortungsvoll zu gestalten, bewusst zu gebrauchen und kritisch zu hinterfragen.

Friedensarbeit @ KHM

Die KHM begegnet diesen kriegerischen Entwicklungen mit bildungspolitischem Widerstand. In Seminaren wie KRIEG UND FERNSEHEN / THE BATTLE SCREEN, Unveiled AI: down the rabbit hole of symbols, ethics and aesthetics, War and Porn – The History of The Internet oder Robots and society, wird kritisch hinterfragt, wie Medien und Technologien gestaltet werden – und welche konkreten gesellschaftlichen Folgen durch sie in Erscheinung treten. Studierende der KHM engagieren und organisieren sich in Netzwerken wie Palestinians and Jews for Peace oder realisieren Kunstausstellungen wie z.B. Cyber Peace Works auf der FIfFKon2318 in Berlin. Die künstlerischen Arbeiten unserer Studierenden hinterfragen nicht nur technische Bild-Sprachen, sondern auch die neue gesellschaftliche Rolle von Kunst- und Kulturarbeiter*innen in der Welt.

Mit Arbeiten wie Informationskrieg – Algorithmen zugunsten populistischer Narrative und Warfluencer – TikTok als Propagandamaschine (Benita Martis) oder bspw. Embedded Politics von Kjell Wistoff und Conrad Weise, öffnen sie Black Boxen mit künstlerischen Mitteln, um technologisch bedingte Verzerrungen, Vorurteile, bis hin zu militärischen Mindsets sichtbar zu machen. Lehrende arbeiten und positionieren sich öffentlich gegen Krieg und für eine sozial gerechte, friedliche, vielfältige und demokratische Welt, wie z.B. die Künstlerin und Gastprofessorin Joana Moll mit The User and the Beast im Performativen auf der Konferenz Investigating the Kill Cloud19, die Schriftstellerin und Professorin Kathrin Röggla in ihrem kürzlich erschienenen Roman Nichts sagen. Nichts hören. Nichts sehen.20 oder auch das Forschungslabor [ ] ground zero, das seit mehreren Jahren im Rahmen verschiedenster Friedenskampagnen, -bewegungen und Forschungsgemeinschaften Friedensarbeit leistet. Im März letzten Jahres veröffentlichte das Forum InformatikerInnen für Frieden (FifF e.V.) und der Arbeitskreis gegen bewaffnete Drohnen, in denen [ ] ground zero seit mehreren Jahren aktiv ist, gemeinsam mit der Informationsstelle Militarisierung e.V. (IMI) ein Positionspapier, in dem wir forderten, Operationen mittels KI-gestützter Führungs- und Entscheidungsunterstützungssysteme als Kriegsverbrechen zu ächten. Seitdem arbeiten wir auf internationaler Ebene an der Umsetzung dieser Forderung21.

***

Die Zivilklausel der KHM ist somit mehr als ein symbolischer Akt. Sie ist ein institutionelles Bekenntnis zu einer Kunst- und Medienpraxis, die sich dem Frieden verpflichtet. Sie ist ein Aufruf zur Verantwortung – an alle, die künstlerisch und gestalterisch mit Medien arbeiten, sie erforschen und lehren. Insbesondere in Zeiten, in denen immer mehr Handlungs- und Entscheidungsmacht an Technologien, Medien und Big Tech Monopole delegiert wird, bis hin zu dem Punkt, dass ihren Algorithmen Funktionen des Tötens eingeschrieben werden, ist es umso notwendiger, aus der Zivilgesellschaft heraus sich Deutungshoheiten über informatische und mediale Räume zurückzuerobern und in politische Debatten mit einzubringen.

Hochschulen sind nicht nur Orte der Kunst- und Wissensproduktion, sondern auch moralische Instanzen. Sie leben die Freiheit von Kunst und Wissenschaft. So muss Bildung für den Frieden mehr als eine Option sein. Sie schafft Möglichkeitsräume für die partizipative und verantwortliche Gestaltung unseres sozialen, gesellschaftlichen und kulturellen Zusammenlebens in nahezu allen Lebens- und Arbeitsbereichen.

Christian Heck, 13. Mai 2025

Lizensiert unter: https://creativecommons.org/licenses/by-sa/4.0/

1Marlene Streeruwitz, Handbuch gegen den Krieg (Wien: bahoe books, 2022).

2Mehr Info auf der Webseite der „Academia under Attack: Konferenz für Wissenschaftsfreiheit und internationale Solidarität“ am 12. und 13. April 2025 in Hamburg unter: https://academia-under-attack.org/ oder auf der zentralen Homepage der Zivilklauselbewegung www.zivilklausel.de.

3Die Kunsthochschule für Medien Köln (KHM) besteht als staatliche Kunsthochschule seit 1990. Im Diplomstudium „Mediale Künste“ und ihrem Promotionsprogramm werden jährlich rund 380 Studierende in den Bereichen exMedia, Film, Kunst und Wissenschaft von einem internationalen Professor*innen- und Mitarbeiter*innenteam, sowie einem Netzwerk aus Fellows und Gastdozierenden betreut. https://www.khm.de/.

4„Artistic and scientific activities in the field of Experimental Informatics at the Academy of Media Arts Cologne (KHM)“, [ ] Ground Zero – Poetics of Technics and Cognition. https://ground-zero.khm.de/.

5Siehe: Yuval Abraham, „‘A Mass Assassination Factory’: Inside Israel’s Calculated Bombing of Gaza“, +972 Magazine, 30. November 2023, https://www.972mag.com/mass-assassination-factory-israel-calculated-bombing-gaza/ und „‘Lavender’: The AI Machine Directing Israel’s Bombing Spree in Gaza“, +972 Magazine, 3. April 2024, https://www.972mag.com/lavender-ai-israeli-army-gaza/.

6Yuval Abraham, „Israel Developing ChatGPT-like Tool That Weaponizes Surveillance of Palestinians“, +972 Magazine, 6. März 2025, https://www.972mag.com/israeli-intelligence-chatgpt-8200-surveillance-ai/.

7„Oscars 2024: Academy entschuldigt sich bei Regisseur Hamdan Ballal“, Der Spiegel, 29. März 2025, https://www.spiegel.de/kultur/oscars-2024-academy-entschuldigt-sich-bei-regisseur-hamdan-ballal-a-d5950326-21b2-4d88-9a87-10c0543b17db.

8Vgl. Simon Kruschinski, Pablo Jost, Hannah Fecher, Tobias Scherer, „Wie bewertet die deutsche Bevölkerung den Einsatz von KI in der Politik?“, OBS-Arbeitspapier, 13. Februar 2025, https://www.otto-brenner-stiftung.de/generative-ki-in-politischen-kampagnen/.

9Carole Cadwalladr, „‘I Spent Seven Years Fighting to Survive’: Chelsea Manning on Whistleblowing and WikiLeaks“, The Observer, 7. Oktober 2018, https://www.theguardian.com/us-news/2018/oct/07/chelsea-manning-wikileaks-whistleblowing-interview-carole-cadwalladr.

10Titel entlehnt von dem gleichnamigen Buch des Medienwissenschaftlers Martin Andree: Big Tech muss weg! – Die Digitalkonzerne zerstören Demokratie und Wirtschaft – wir werden sie stoppen (Frankfurt am Main: Campus Verlag, 2023).

11Eric Mülling, „Workshop: Big Data und der digitale Ungehorsam“, Vortragsfolien, 15. Oktober 2016, https://docplayer.org/177473931-Workshop-big-data-und-der-digitale-ungehorsam.html.

12Zum Vergleich: Die ‘Usage Policy’ von OpenAI vor dem 10. Januar 2024 unter https://web.archive.org/web/20240109122522/https:/openai.com/policies/usage-policies. In der heutigen Version wurde unter „Disallowed usage of our models“ der Punkt „Weapons development; Military and warfare“ gelöscht: https://openai.com/policies/usage-policies.

13Wolfgang Walk, „Der Aufstieg der KI im Militär: Wie das Pentagon mit ‚Thunderforge‘ die Kriegsplanung revolutioniert“, TZG – Technologie Zeitgeist, 6. März 2025, https://www.techzeitgeist.de/der-aufstieg-der-ki-im-militaer-wie-das-pentagon-mit-thunderforge-die-kriegsplanung-revolutioniert/.

14Marwa Fatafta, „How Meta Censors Palestinian Voices“, Access Now, 19. Februar 2024, https://www.accessnow.org/publication/how-meta-censors-palestinian-voices/.

15Yuval Abraham, „Israel Developing ChatGPT-like Tool That Weaponizes Surveillance of Palestinians“, +972 Magazine, 6. März 2025, https://www.972mag.com/israeli-intelligence-chatgpt-8200-surveillance-ai/.

16„Hito Steyerl: I Will Survive“, Skylight Books, https://www.skylightbooks.com/book/9783959054195.

17Vilém Flusser, Für eine Philosophie der Fotografie (Göttingen: European Photography, 1983), https://vdoc.pub/documents/fr-eine-philosophie-der-fotografie-cg4q74jac760.

18„FIfF-Konferenzen Archiv“, FIfF e.V., https://www.fiffkon.de/.

19„Investigating the Kill Cloud“, Disruption Network Lab, https://www.disruptionlab.org/investigating-the-kill-cloud.

20Kathrin Röggla, Nichts sagen. Nichts hören. Nichts sehen. – (Berlin: S. Fischer Verlag, 2025).

21Mehr Info unter: „Senkung der Hemmschwelle durch den Einsatz von Künstlicher Intelligenz – Lavender und Co. sind als Kriegsverbrechen einzustufen“, FIfF e.V., 29. April 2024, https://blog.fiff.de/warnung-senkung-der-hemmschwelle-durch-kuenstliche-intelligenz/.