AI sthesis

Aesthetics of Artificial Intelligences

[ ] ground zero @ KHM Rundgang 2023

How can we bring machines to life or bring life to machines? Where is the magic in these technical cognitive systems and how do we unfold their aesthetic potential? How democracythreatening are AI ‘s in social media? Is it possible to reveal parts of this WhiteBox in a black dress through Bertold Brecht’s Alienation effect? How do we connect historicities in diffusion models á la StableDiffusion with Harsh Noise Music?

These and other questions were asked installatively and performatively as student talks and lecture performances from Benita Martis, Lisa Reutelsterz, Ting Chun Liu, Leon-Etienne Kühr and Pedro A. Ramirez.

Credits: Dörthe Boxberg

Aesthetics of Artificial Intelligences

Artificial intelligences (AI’s) have become an integral part of digital applications and thus part of our everyday experience. As integrated functions in standard tools such as web browsers, social media apps or Photoshop, they shape our sensory perceptions and thus challenge art to take a stand on this technology. In the [ ]ground zero lab, students engage not only with the programming, technical developments, and history of ideas of AI, but also with the philosophical questions and, in particular, the aesthetic aspects and repercussions on our sensory perceptions and experiences.

How can we bring machines to life or bring life to machines? This question already occupied the Greek mathematician and engineer Heron of Alexandria 2000 years ago. From antiquity to the famous mechanical androids of the Jaquet-Droz family in the 18th century to today’s artificial neural networks and robots, social dystopias and fascination with technological progress have always been inextricably linked. The philosophical questions raised by advanced technologies also form the core of current ethical discourses, which Lisa Reutelsterz traces in her artistic practice.

Speech and image generators such as ChatGPT, DALL-E, Midjourney or Stable Diffusion write texts or create images on the basis of huge data sets from the Internet, which serve as training material for the machine learning methods of neural networks. These systems often deliver surprising but also hardly comprehensible results. They have a “black box” character, since the exact processes and decision-making paths within the neural networks cannot be directly viewed and explained. It is difficult to understand which aspects of a training dataset are responsible for certain outputs. Ting Chun Liu and Leon-Etienne Kühr question the magic of these systems and explore their aesthetic potential in experimental feedbacks and interconnections of different applications to generative chains and loops.

While the global tech elite presents the use of AI as “technology for good,” these same technologies are also used as weapons in war. Drones are trained to identify and eliminate potential threats, costing the lives of many innocent civilians over the last 20 years. Social bots (= AI’s in social networks) provided Fake News in Trump’s election campaign. Russia is currently using social networks as a propaganda channel in the information war against Ukraine. These downsides, which threaten democracy, are reflected in Benita Martis’ work as an aesthetic experience of difference.

During the Rundgang, [ ]ground zero offers insights into the students’ aesthetic explorations of artificial intelligences. More detailed information on the lecture performances and individual works can be found here:

Wednesday 19.07 | 18 – 21h

Thursday 20.07 | 14 – 20h

Friday 21.07 | 14 – 20h

Lecture Performances

> 16:00h “Information war – social feedback”, Benita Martis (language: German)

> 17:00h “How to find the happiest person with AI?”, Ting Chun Liu (language: English)

> 18:00h “Noise: Dithering, Cut-up and the Diffused Aesthetic Glossolalia”, Pedro Ramirez (language: English)

Saturday 22.07 | 14 – 20h

Lecture Performances

> 16:00h “Reflecting Affective AI”, Lisa Reutelsterz (Language: German)

> 17:00h “Stable Diffusion – artistic exploration”, Leon-Etienne Kühr (language: German/English)

Sunday 23.07 | 14 – 20h

Installations

Wednesday – Sunday

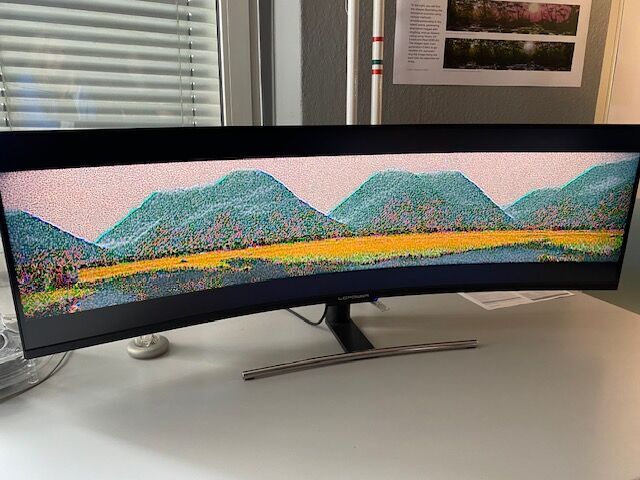

Imaginary Landscape

Ting Chun Liu

The beach has always been a tourist attraction since the Age of Enlightenment. With the advent of mass tourism and social media, idealised images of the beach have become mixed with reality, leading to extensive human intervention and terraforming along coastlines worldwide. Based on this notion of beach beauty, the project explores the concept of one-sided realities portrayed in travel images on social media. It uncovers the technical and aesthetic properties of state-of-the-art image generation models through AI.

The Installation is part of a series of projects that explore the idea of the beach as a destination: Imaginary Landscape. The Project consists of several audiovisual performances that work with Processing and Max/MSP and use StableDiffusion images as a source.

more info, see: imaginary-landscape

Wednesday – Sunday

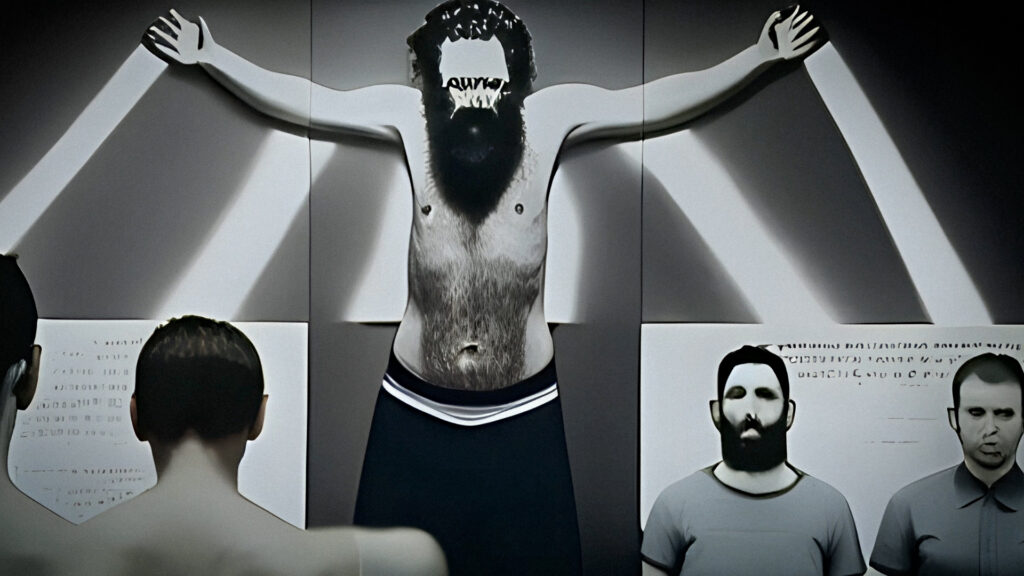

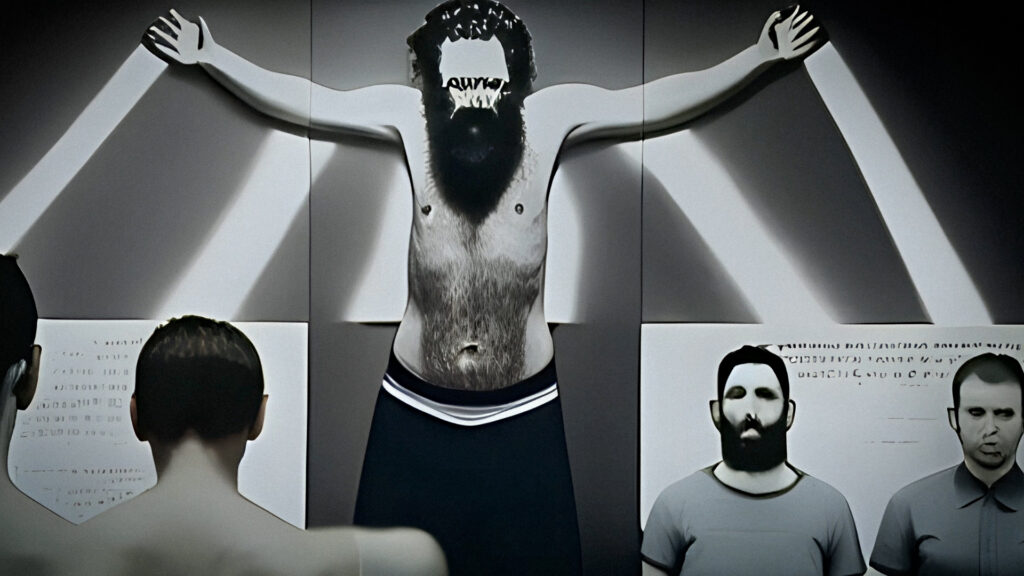

[John & Mary] by artificial and non-artificial systems

Lisa Reutelsterz

Can a machine express itself in terms of emotion or pain? What do we as human viewers understand about it? [John and Mary] is an audio-visual experiment that blurs the boundaries between natural and artificial systems, emotions and their machine reproduction. Poems were generated using a large language model (LLM), then read line by line into image diffusion models to create synthetic videos. These were presented out of context to different authors to capture their individual interpretation of the videos, which can be heard in VoiceOver. Within dreamlike sequences, a maelstrom is created that seduces us to grasp meaning in the images and demonstrates a tension between machine and human semantics. Abstractions and ambiguities open up new spaces of meaning. The question arises as to what is original and how man and machine can be distinguished from each other, as well as the power of society.

Direction/Concept/Montage: Lisa Reutelsterz Poems/Spoken by: Jan Reutelsterz, Björn Gabriel, Stephan Weigelin, Anna Marienfeld, Benita Martis, Nina Berner Sound: Jan & Lisa Reutelsterz

more info, see: [john-and-mary/]

Performance Lectures

Friday, 16:00h

Informationskrieg – Social Feedback

Benita Martis

Large pre-trained AI text generators are capable of generating propagandistic language that, at first glance, can hardly be distinguished from propaganda written by humans. Only upon closer examination do varying degrees of artificial intelligence traces become apparent in the form of syntactic and semantic errors. The game of misinformation and conspiracy myths confronts users with a critical examination of their own handling of information in social networks.

Friday, 17:00h

How to find the happiest person with AI?

Ting Chun Liu

What is the ultimate happiness in the machine? Regardless of Stable Diffusion, MidJourney, or Dall-E, all these generative models that translate text into images are based on Contrastive Language-Image Pre-training (CLIP). It proposed the idea of digitizing text. In this way, calculating the distance between words and establishing correlations and clusters became possible. However, the process of building such a method relies on numerous languages in the training process, thus presenting the bias that the database has. The lecture will discuss the use case of CLIP, including NFSW content filter, image generation model and so on. Experimenting on the border of text clusters, finding whether the happiest person CLIP would recognize. Exposing bias in CLIP is like telling the bias shared by many generative artificial intelligence today.

Friday, 18:00h

Noise: Dithering, Cut-up and the Diffused Aesthetic Glossolalia

Pedro Ramirez

Lecture performance exploring the ideas of disruption and expansion of meaning through the concept of noise… Touching on explorations such as the oracle of Delphi, glossolalia, speaking in tongues, the Electronic Voice Phenomenon used in paranormal investigation practices, Burroughs and it’s cut-up method/Harsh Noise Music and the usage of noise in image processing such as dithering or more recently in image generation Diffusion Models…

Saturday, 16:00h

Reflecting Affective AI

Lisa Reutelsterz

The fact that emotions are one of the fundamental bases of our moral actions and social coexistence makes us think about the extent to which artificial systems and machines can and should understand, simulate or even embody them. About a multimedia and artistic approach to the coding of morality, fear and pain.

Saturday, 17:00h

Stable Diffusion – artistic exploration

Leon-Etienne Kühr

Current text-to-image generators like Stable Diffusion appear as black boxes with clear input and output. Within a few seconds, the input text is transformed into a corresponding image. But take a peek inside the AI black box and you’ll discover a complex pipeline of trained algorithms. Each part of this carefully tuned pipeline has its own role with inputs and outputs, biases and characteristics. It is only in the complex and controlled interaction of the individual components that it becomes possible to establish a connection between image and text, input and output. But what happens when the components of the pipeline are rearranged, confronted with their own output, algorithms applied several times or linked in a new way? What image worlds emerge and what peculiarities of the algorithms are revealed when they work outside their usual comfort zone?

Die Ästhetiken Künstlicher Intelligenzen

Künstliche Intelligenzen (KI‘s) sind mittlerweile integraler Bestandteil digitaler Anwendungen und damit Teil unserer Alltagserfahrung. Als integrierte Funktionen in Standardwerkzeugen wie Webbrowsern, Social Media Apps oder Photoshop prägen sie unsere Sinneswahrnehmungen und fordern damit die Kunst heraus, Stellung zu dieser Technologie zu beziehen. Im Labor [ ]ground zero beschäftigen sich die Studierenden nicht nur mit der Programmierung, den technischen Entwicklungen und der Ideengeschichte der KI, sondern auch mit den philosophischen Fragen und insbesondere den ästhetischen Aspekten und Rückwirkungen auf unsere sinnlichen Wahrnehmungen und Erfahrungen.

Wie können wir Maschinen zum Leben erwecken oder Leben in die Maschinen bringen? Diese Frage hat schon vor 2000 Jahren den griechischen Mathematiker und Ingenieur Heron von Alexandria beschäftigt. Von der Antike über die berühmten mechanischen Androiden der Familie Jaquet-Droz im 18. Jahrhundert bis zu den heutigen künstlichen neuronalen Netzen und Robotern waren gesellschaftliche Dystopien und die Faszination für den technischen Fortschritt immer untrennbar verbunden. Die durch avancierte Technologien aufgeworfenen philosophischen Fragen bilden auch den Kern derzeitiger ethischer Diskurse, denen Lisa Reutelsterz in ihrer künstlerischen Praxis nachspürt.

Sprach- und Bildgeneratoren wie ChatGPT, DALL-E, Midjourney oder Stable Diffusion schreiben Texte oder kreieren Bilder auf der Basis riesiger Datensätze des Internets, die den maschinellen Lernverfahren der neuronalen Netze als Trainingsmaterial dienen. Diese Systeme liefern oft überraschende aber auch kaum nachvollziehbare Ergebnisse. Sie haben einen „Black-Box“-Charakter, da die genauen Prozesse und Entscheidungswege innerhalb der neuronalen Netze nicht direkt einsehbar und erklärbar sind. Es ist schwer zu verstehen, welche Aspekte eines Trainingsdatensatzes für bestimmte Ausgaben verantwortlich sind. Ting Chun Liu und Leon-Etienne Kühr hinterfragen die Magie dieser Systeme und untersuchen ihr ästhetisches Potential in experimentellen Feedbacks und Verschaltungen verschiedener Anwendungen zu generativen Ketten und Loops.

Während die globale Tech-Elite den Einsatz von KI als „technology for good“ präsentiert, werden dieselben Technologien auch als Waffe im Krieg eingesetzt. Drohnen sind darauf trainiert, mögliche Gefährder zu identifizieren und auszuschalten, was in den letzten 20 Jahren vielen unschuldigen Zivilisten das Leben kostete. Social Bots (= KIs in sozialen Netzwerken) sorgten in Trumps Wahlkampf für Fake News. Russland nutzt gegenwärtig gezielt soziale Netzwerke als propagandistisches Sprachrohr im Informationskrieg gegen die Ukraine. Diese demokratiegefährdenden Kehrseiten spiegeln sich in der Arbeit von Benita Martis als ästhetische Differenzerfahrung wider.

Während des Rundgangs bietet [ ]ground zero Einblicke in die ästhetischen Auseinandersetzungen der Studierenden mit Künstlicher Intelligenz. Genauere Informationen zu den Lecture Performances und einzelnen Arbeiten finden Sie hier:

Mittwoch 19.07 | 18 – 21h

Donnerstag 20.07 | 14 – 20h

Freitag 21.07 | 14 – 20h

Lecture Performances

> 16:00h »Informationskrieg – Social Feedback«, Benita Martis (Sprache: Deutsch)

> 17:00h »How to find the happiest person with AI?«, Ting Chun Liu (Sprache: Englisch)

> 18:00h »Noise: Dithering, Cut-up and the Diffused Aesthetic Glossolalia«, Pedro Ramirez (Sprache: Englisch)

Samstag 22.07 | 14 – 20h

Lecture Performances

> 16:00h »Reflecting Affective AI«, Lisa Reutelsterz (Sprache: Deutsch)

> 17:00h »Stable Diffusion – artistic exploration«, Leon-Etienne Kühr (Sprache: Deutsch/Englisch)

Sonntag 23.07 | 14 – 20h

Installationen

Mittwochs – Sonntag

Imaginary Landscape

Ting Chun Liu

Der Strand war seit der Aufklärung immer eine Touristenattraktion. Mit dem Aufkommen des Massentourismus und der sozialen Medien haben sich die idealisierten Strandbilder mit der Realität vermischt, was zu umfangreichen menschlichen Eingriffen und Terraforming entlang der Küsten weltweit geführt hat. Ausgehend von dieser Vorstellung von der Schönheit des Strandes erforscht das Projekt das Konzept der einseitigen Realitäten, die in Reisebildern in den sozialen Medien dargestellt werden. Es deckt die technischen und ästhetischen Eigenschaften modernster Bilderzeugungsmodelle durch KI auf.

Die Installation ist Teil einer Reihe von Projekten, die sich mit der Idee des Strandes als Reiseziel beschäftigen: Imaginary Landscape. Das Projekt besteht aus mehreren audiovisuellen Performances, die mit Processing und Max/MSP arbeiten und StableDiffusion Images als Quelle verwenden.

Mittwochs – Sonntag

[John & Mary] by artificial and non-artificial systems

Lisa Reutelsterz

Kann sich eine Maschine in Bezug auf Emotionen oder Schmerzempfinden ausdrücken? Was verstehen wir als menschliche Betrachter davon? [John and Mary] ist ein audiovisuelles Experiment, das die Grenzen von natürlichen und künstlichen Systemen, Emotionen und ihrer maschinellen Reproduktion verwischt. Gedichte wurden mithilfe eines KI-Sprachmodells (LLM) generiert, dann zeilenweise in Bilddiffusionsmodelle eingelesen, um synthetische Videos zu erzeugen. Diese wurden kontextlos verschiedenen Autoren präsentiert, um ihre individuelle Interpretation der Videos zu erfassen, was im VoiceOver zu hören ist. Innerhalb traumartiger Sequenzen entsteht ein Sog, der dazu verführt, in den Bildern Bedeutung zu fassen und der ein Spannungsverhältnis zwischen maschineller und menschlicher Semantik zeigt. Abstraktionen und Mehrdeutigkeiten eröffnen neue Bedeutungsräume. Es stellt sich die Frage nach dem Ursprünglichen und nach der Unterscheidbarkeit von Mensch und Maschine sowie der gesellschaftlichen Wirkmacht.

Regie/Konzept/Montage: Lisa Reutelsterz Gedichte/Gesprochen von: Jan Reutelsterz, Björn Gabriel, Stephan Weigelin, Anna Marienfeld, Benita Martis, Nina Berner Sound: Jan & Lisa Reutelsterz

Performance Lectures

Freitag, 16:00h

Informationskrieg – Social Feedback

Benita Martis

Große vortrainierte KI-Textgeneratoren sind dazu in der Lage propagandistische Sprache zu generieren, die auf den ersten Blick kaum von Menschen verfasster Propaganda zu unterscheiden ist. Erst bei genauerer Überprüfung werden unterschiedlich starke Spuren künstlicher Intelligenz in Form von syntaktischen und semantischen Fehlern erkennbar. Das Spiel aus Falschinformationen und Verschwörungsmythen stellt Nutzer*innen vor eine kritische Betrachtung ihres eigenen Umgangs mit Informationen in sozialen Netzwerken.

Freitag, 17:00h

Wie findet man mit KI den glücklichsten Menschen?

Ting Chun Liu

Was ist das ultimative Glück in der Maschine? Ob Stable Diffusion, MidJourney oder Dall-E, all diese generativen Modelle, die Text in Bilder übersetzen, basieren auf Contrastive Language-Image Pre-training (CLIP). Dabei wird die Idee der Digitalisierung von Text vorgeschlagen. Auf diese Weise wurde es möglich, den Abstand zwischen Wörtern zu berechnen und Korrelationen und Cluster zu erstellen. Der Aufbau einer solchen Methode stützt sich jedoch auf zahlreiche Sprachen im Trainingsprozess, wodurch die Verzerrungen in der Datenbank deutlich werden. In dem Vortrag wird der Anwendungsfall von CLIP erörtert, einschließlich des NFSW-Inhaltsfilters, des Bilderzeugungsmodells und so weiter. Experimentieren an der Grenze von Textclustern, um herauszufinden, ob die glücklichste Person von CLIP erkannt werden kann. Die Aufdeckung der Voreingenommenheit von CLIP ist vergleichbar mit der Aufdeckung der Voreingenommenheit, die viele generative künstliche Intelligenzen heute aufweisen.

Freitag, 18:00h

Noise: Dithering, Cut-up und die diffus-ästhetische Glossolalie

Pedro Ramirez

Lecture Performance, die die Ideen der Unterbrechung und Erweiterung von Bedeutung durch Konzepte des Rauschens (Noise) erforscht, mit Fokus auf die Technik des Dithering (Fehlerdiffusion), einer Verwendung von Rauschen in der Bildverarbeitung, sowie auch in der Bilderzeugung durch Diffusionsmodelle (Stable Diffusion etc.)

Ein experimenteller Streifzug durch das Orakel von Delphi, Glossolalien, dem doppelzüngigen Sprechen, dem Electronic Voice Phänomen, das in paranormalen Untersuchungspraktiken verwendet wird, W. S. Burroughs und seine Cut-up-Methode und Harsh Noise Music.

Samstag, 16:00h

Reflecting Affective AI

Lisa Reutelsterz

Die Tatsache, dass Emotionen eine der fundamentalen Grundlagen unseres moralischen Handelns und gesellschaftlichen Zusammenlebens sind, lässt uns darüber nachdenken, inwiefern auch künstliche Systeme und Maschinen diese verstehen, simulieren oder sogar verkörpern können und sollten. Über eine multimediale und künstlerische Annäherung der Codierung von Moral, Angst und Schmerz.

Samstag, 17:00h

Stable Diffusion – artistic exploration

Leon-Etienne Kühr

Aktuelle Text-zu-Bild-Generatoren wie Stable Diffusion erscheinen als Blackboxes mit klarem In- und Output. Innerhalb weniger Sekunden wird der eingegebene Text in ein entsprechendes Bild transformiert. Doch wirft man einen Blick in die AI-Blackbox, entdeckt man eine komplexe Pipeline von trainierten Algorithmen. Jeder Teil dieser sorgfältig abgestimmten Pipeline hat eine eigene Rolle mit In- und Outputs, Biases und Eigenheiten. Erst im komplexen und kontrollieren Zusammenspiel der einzelnen Bestandteile wird es möglich, einen Zusammenhang zwischen Bild und Text, In- und Output herzustellen. Doch was passiert, wenn man die Bestandteile der Pipeline neu anordnet, mit dem eigenen Output konfrontiert, Algorithmen mehrmals anwendet oder neu verknüpft? Welche Bilderwelten entstehen und welche Eigenheiten der Algorithmen werden offenbart, wenn diese außerhalb ihrer gewohnten Komfortzone arbeiten?